Die Einwohnerzahl von Berlin ändert sich ständig. Jedes Jahr, wenn die neuen Zahlen veröffentlicht werden, setzt sich ein Wikipedia-Autor an den Eintrag über Berlin und aktualisiert ihn. Allerdings müsste die Zahl in jeder Ausgabe der Wikipedia von Hand geändert werden, von der englischen bis zur turkmenischen. Das soll anders werden, sagt Pavel Richter, Vorstand des Vereins Wikimedia Deutschland.

Ab dem 2. April wird ein Team aus zwölf Entwicklern in Berlin am Projekt Wikidata arbeiten. Es ist der offizielle Startschuss für ein Projekt, über das die Wikipedia-Community jahrelang diskutiert hat. „Wikidata ist die Wikipedia für Daten“, sagt Richter. Ziel ist, eine Datenbank aus strukturierten, frei zugänglichen Informationen zu schaffen, die jeder bearbeiten kann. Davon sollen auch die Wikipedia-Ausgaben in aller Welt profitieren.

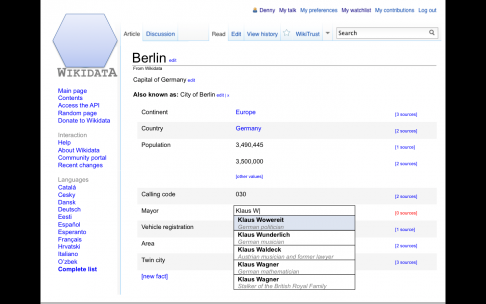

Eines der ersten Ziele des Projektes ist es, die Daten in den Infoboxen von Wikipedia-Artikeln über Orte, Staaten oder Personen maschinenlesbar aufzubereiten. Denn so könnte die Datenbank alle Wikipedia-Ausgaben gleichzeitig füttern: Aktualisiert jemand die Einwohnerzahl von Berlin, wird diese Änderungen automatisch in allen Sprachausgaben sichtbar. Für die Editoren wäre das eine spürbare Erleichterung.

Doch Richter sagt, dass das Projekt seines Vereins auch anderen zugute kommen soll: „Wikidata stellt die Daten als Variablen zur Verfügung. Jeder, der sie haben möchte, kann sie für seine Zwecke einbinden.“ So ließen sich dynamische Listen erstellen, etwa der zehn größten Städte der Welt, die von einer Frau regiert werden, die älter ist als… Solche Abfragen könnten beliebig komplex sein, je nach Sinn und Zweck.

Auch Visualisierungen der Daten wären möglich. Das jedoch müssten andere übernehmen, es ist nicht Ziel und Aufgabe des Projektteams. Die zwölf Entwickler programmieren erst einmal nur die Datenbank – als Datenquelle, die ihrerseits sagt, woher die Rohdaten stammen.

Geplant sei, sagt Richter, das Projekt innerhalb eines Jahres in mehreren Modulen umzusetzen. Erste Ergebnisse sollen bereits im Juli oder August präsentiert werden. Schnell folgen müsste aber auch eine Schnittstelle, über die man neue Daten einspeisen kann.

Finanziert wird Wikidata durch Spenden. Wer die ersten namhaften Spender sind, will Wikimedia Deutschland am heutigen Freitag bekanntgeben. Zu den Großspendern gehören das Allen Institute for Artificial Intelligence, das die Hälfte des Gesamtbudgets von 1,3 Millionen Euro übernimmt, die Gordon and Betty Moore Foundation, die ein Viertel der Entwicklungskosten von Wikidata trägt, sowie Google, das ein weiteres Viertel der Kosten übernimmt.

Neben Geld braucht das Projekt aber noch eine andere Art von Spenden: Datenspenden. Eine leere Datenbank hilft niemandem. Richter sagt, man werde gezielt Institutionen ansprechen, die auf großen Datenbergen sitzen und sie fragen, ob sie diese der Allgemeinheit zur Verfügung stellen könnten.

Es wird also noch dauern, bis die Datenbank von Dritten genutzt werden kann. Für die Open-Data-Bewegung hierzulande ist es aber in jedem Fall ein gutes Zeichen, wenn sich ein so bekannter Verein wie Wikimedia Deutschland um die Förderung von freien Daten bemüht.

Für weitere Informationen lohnt sich ein Blick ins Metawiki zu zum Projekt Wikidata: Dort ist unter anderem ein früher Prototyp einer Benutzeroberfläche zu sehen.