Seit vergangenem Jahr ist weitläufig bekannt: Onlinejournalismus kann mit großen Datensätzen eine neue Form der Berichterstattung leisten – Stichwort WikiLeaks. Der so genannte Datenjournalismus oder data-driven-journalism hat nützliche Erzählmethoden hervorgebracht. Der umstrittene Julian Assange spricht auch von „wissenschaftlichen Journalismus“, der sich ausschließlich an der Faktenlage sowie den vorliegenden Daten orientiert und die Meinung sowie Wertung des Autors gänzlich zurücktreten lässt. Und schon 2006 legte der programmierende Journalist Adrian Holovaty aus den USA dar, warum sich Nachrichtenseiten im Netz angesichts der wachsenden Datenmenge fundamental ändern sollten.

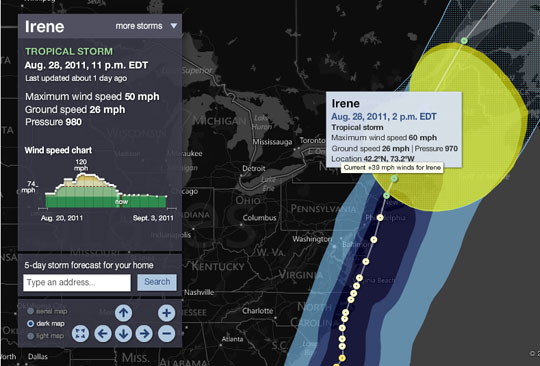

Jüngst war zu beobachten, wie sinnvoll Datenjournalismus auch in der tagesaktuellen Berichterstattung sein kann: Während der Hurrikan Irene drohte, New York mit voller Wucht zu treffen, boten einige Onlinemedien in den USA interaktive Visualisierungen an. Diese beruhten auf Open Data der US-Wetterbehörde und boten die Möglichkeit, den voraussichtlichen Weg des Hurrikans vorzuzeichnen. Siehe etwa die New York Times (NYT) oder MSNBC (die jeden Sturm verfolgen). Darüber hinaus bot die NYT eine interaktive Karte mit den Evakuierungszonen und zeigte die Folgen des Sturms für die Region.

In der deutschen Medienlandschaft sind solche Beispiele von aktuellem Datenjournalismus noch selten. Keines der großen Medienhäuser hat offenbar entsprechendes Personal, um innerhalb von wenigen Tagen oder gar Stunden mit interaktiven Schilderungen von Vorgängen aufzuwarten.

Datenjournalismus ist hierzulande ein zartes Pflänzchen; dabei ist seit den hervorragenden Arbeiten des Guardian und der New York Times zu den Kriegstagebüchern im Sommer 2010 nunmehr ein Jahr vergangen. Bis auf wenige Ausnahmen, unter anderem auf ZEIT ONLINE, scheint Datenjournalismus ein Fremdwort in vielen Redaktionen zu sein. Dabei lässt er sich einfach umsetzen, wie etwa der Tagesspiegel zeigt. Angelehnt an das eingestellte Webprojekt brennende-autos.de dokumentierte das Blatt jüngst eine Zeit lang die Autobrände in Berlin auf einer Google-Karte.

Im Großen und Ganzen vergeben Redaktionen und Verlage eine Chance, den eigenen Lesern neue Wege der Berichterstattung über Hintergründe zu eröffnen. Zudem wird verpasst, zeitgemäß der eigenen Rolle gerecht zu werden und als demokratisches Korrektiv, als „Watchdog“, zu fungieren.

Zwei Beispiele, die geradezu nach einer datenjournalistischen Bearbeitungen schreien:

Kaum ein Thema hat in jüngster Zeit so viele innenpolitische Wellen geschlagen wie das Bahnprojekt Stuttgart 21. In der Presse gab es zur Aufbereitung zwar einiges an Visualisierung. In der Regel aber ging es um den Streckenverlauf und die Lage des Neubaus unter der Erde sowie die Folgen für die Stuttgarter Innenstadt. Die Kapazität des Neubaus aber, also die Frage, ob er wirklich schnelleres und besseres Reisen ermöglicht, wurde nicht betrachtet.

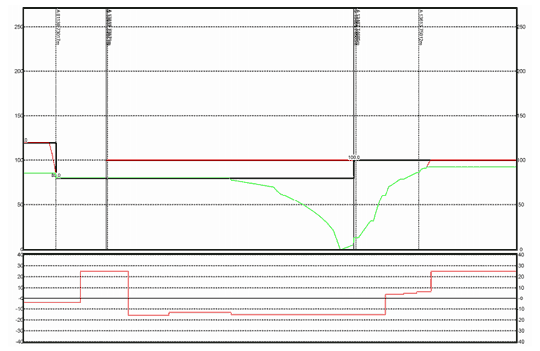

Dabei hätte sich spätestens die Simulation des Streckenbetriebs, der sogenannte Stresstest im Frühsommer, ideal für ein datenjournalistisches Projekt angeboten. Der komplizierte Sachverhalt hätte online in einer interaktiven Grafik präsentiert werden können, die der Nutzer steuern kann: Indem beispielsweise die Zugtaktung erhöht oder verringert wird. So hätte sichtbar werden können, wie der geplante Bahnhof diese Veränderungen verkraftet.

Sicherlich kein einfaches Unterfangen, wie der Abschlussbericht der Bahn zum Stresstest zeigt (pdf). Der ist weitgehend von Fachjargon und Datenkauderwelsch geprägt. Aber eben auch durch viele Fakten: Der Simulationsbereich umfasste 360 Stationen und Bahnhöfe, 1.800 Gleiskilometer, 2.500 Weichen und 5.400 Signale. Die datenjournalistische Aufbereitung eines solchen komplexen Systems wäre sicherlich zu aufwändig. Aber man hätte ohne Weiteres in einer interaktiven, datenbasierten Anwendung erleb- und erfahrbar machen können, wie so ein Stresstest prinzipiell funktioniert.

Während der Zug in Sachen Stuttgart 21 inzwischen im wahrsten Sinne des Wortes abgefahren ist, wird auch ein anderer, wichtiger Themenkomplex bislang vernachlässigt. Der gesamte Finanz- und Wirtschaftsbereich strotzt nur so vor Datensätzen, die oft in Echtzeit vorliegen. Rund um die Uhr, jeden Tag im Jahr. Doch die einzige Visualisierungsform ist seit journalistischen Urzeiten der Graph: Der Dax fällt, er steigt, der Dax stürzt ab und erholt sich wieder und so weiter.

Geld und Finanzmärkte sind abstrakt, keine Frage. Aber gerade deshalb sollte Journalismus hier aufklärerisch wirken. Wie wichtig das ist, hat die Vergangenheit gezeigt: Nahezu alle Finanzjournalisten haben das Hohelied der Deregulierung gesungen und dabei versagt, die Immobilienblase in den USA und folgende Finanzkrise rechtzeitig zu erkennen. Klassische Infografiken können hier nur an der Oberfläche kratzen. Die Gefahr ist, dass es dabei mit verspielter Ästhetik übertrieben wird. Auch gut gemachte Grafiken von aufeinander gestapelten Dollarscheinen berichten nichts über die Zusammenhänge. Spötter sprechen daher auch von „visualisation porn“.

Datenjournalismus könnte neue Wege zum Thema Finanzmarkt ebnen: Wenn die Staaten so viel Geld schulden – wer sind die Gläubiger? Wer sind die Gewinner, wenn andere verlieren? Wo ist das Geld hin, das der Staat bei der „Bankenrettung“ ausgegeben hat? Die Finanzberatungsfirma Bloomberg zeigt das beispielsweise in einer interaktiven Anwendung für die Banken der USA.

Es gibt ungezählte weitere Herausforderungen für den Datenjournalismus. Politische Vorgänge, Kriege, Klima, Rohstoffpreise, Nahrungsmittel- und Klimabörsen – all diese Themen hängt miteinander zusammen und eben diese Zusammenhänge können per interaktiven Anwendungen auf den Punkt gebracht werden.

Es ist an der Zeit, dass deutsche Medien dem Datenjournalismus mehr Raum geben, ihn fördern und anwenden. Im eigenen Interesse: Die Tatsache, dass Informationsangebote im Netz dynamisch auf Datenbanken und andere Webdienste zurückgreifen, ist ihr Alleinstellungsmerkmal gegenüber Print- und Rundfunkmedien. Eine so wegweisende wie spannende Chance für den Onlinejournalismus.