Nein, er war nicht dabei. Diesmal jedenfalls nicht. Aber es ging ja auch nicht um so aufmerksamkeitsträchtige Themen wie den Schutz verfolgter Online-Dissidenten in totalitären Regimen. Kein Kampf für die Verfolgten dieser Erde. Keine Schlagzeilen als Retter in der Not. Kein mediales Greenwashing des talentierten Freiherrn zu Guttenberg. Es ging nur um spröde Daten. Die liegen nach Angaben der EU-Kommissarin für die Digitalstrategie des Staatenbundes, Neelie Kroes, in den umfangreichen Archiven und den gewaltigen Datenbanken der öffentlichen Verwaltungen der Europäischen Union. Dort warten sie nun geradezu darauf, von der Öffentlichkeit entdeckt zu werden. Die Rede ist von der Nutzung öffentlicher Daten als Goldmine. So betitelte das Ressort der EU-Kommissarin in dieser Woche die Ankündigung einer neuen Open-Data-Strategie der Europäischen Union.

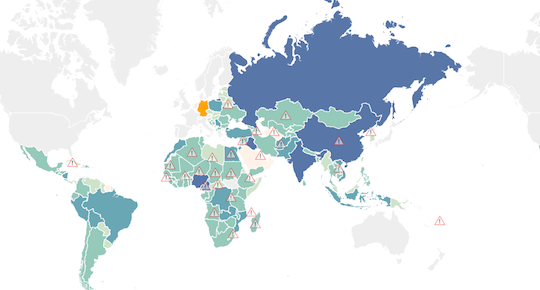

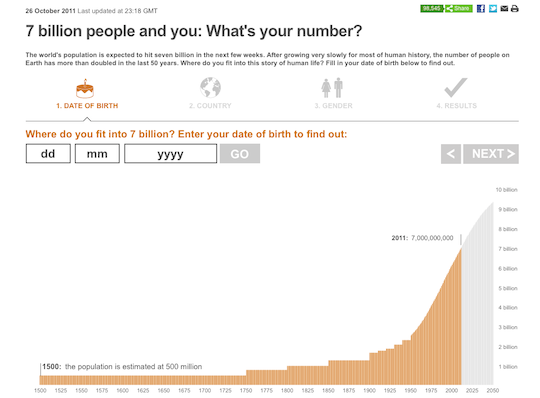

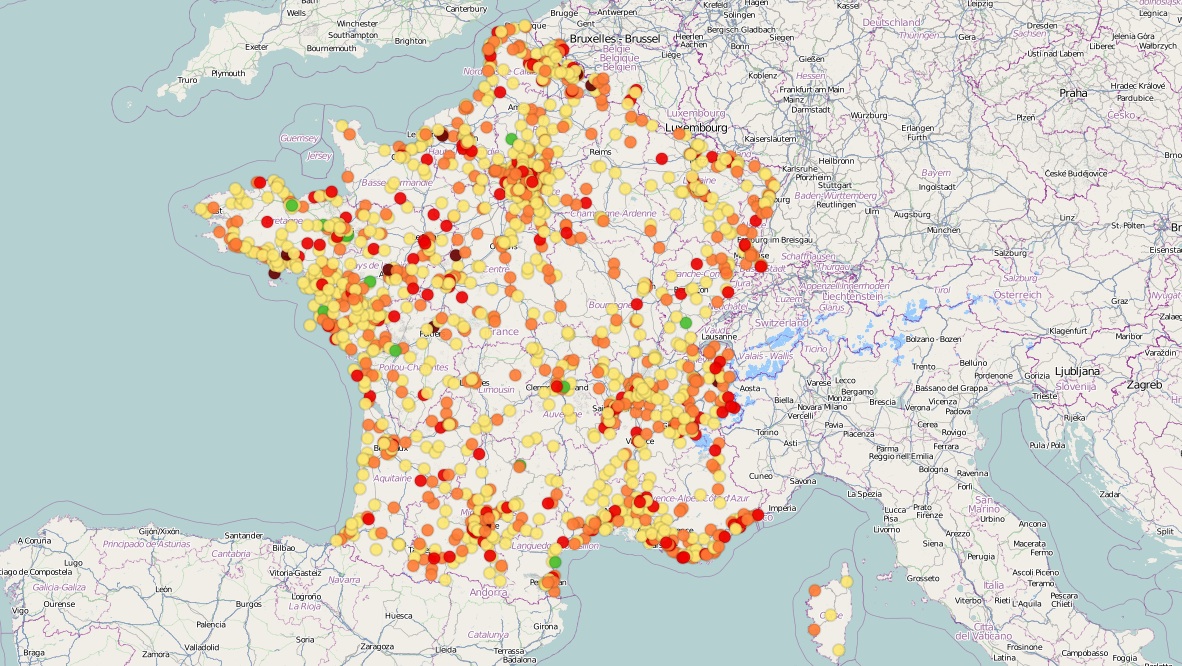

Die mit dieser neuen Strategie verknüpften wirtschaftlichen Hoffnungen sind alles andere als bescheiden. Ein schlafender Schatz im Wert von 40 Milliarden Euro (in Zahlen: 40.000.000.000) soll den strapazierten Ökonomien des Kontinents neuen Schwung verpassen. Die Vorgehensweise orientiert sich unter anderem an Frankreich und Großbritannien, die seit einiger Zeit positive Erfahrungen mit dem Angebot eigener Open-Data-Portale machen. In Großbritannien ist data.gov.uk bereits seit Jahren öffentlich und auch data.gouv.fr erfreut sich in Frankreich eines regen Interesses. Aus drei Teilen besteht nun die Strategie der EU:

Erstens wird die Kommission mit gutem Beispiel vorangehen und der Öffentlichkeit ihre Informationsschätze kostenlos über ein neues Datenportal zugänglich machen. Zweitens werden überall in der EU gleiche Wettbewerbsbedingungen in Bezug auf offene Daten geschaffen. Drittens werden für diese neuen Maßnahmen 100 Millionen Euro bereitgestellt, die im Zeitraum 2011–2013 für Forschungsarbeiten zu besseren Technologien im Umgang mit diesen Daten ausgegeben werden sollen.

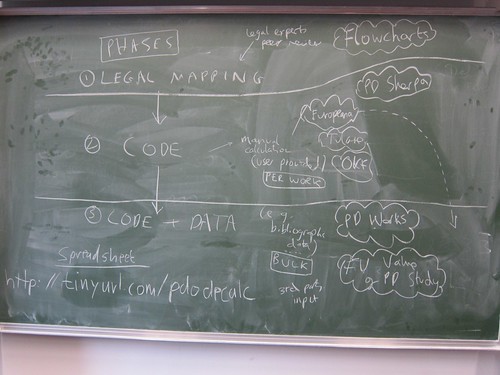

Gerade die Forschung und Entwicklung neuer Technologien dürfte entscheidend für den Erfolg der Strategie sein. Zuletzt hatte Viktor Meyer-Schönberger auf die großen Defizite der Open-Data-Bewegung hingewiesen (Link zum PDF der Meyer Schönberger Studie: Participation and Power Intermediaries of Open Data; ein Interview dazu in Kürze). Seines Erachtens mangelt es vor allem an konzertierten Aktivitäten staatlicher und freier Akteure. Außerdem fehlen die Masterpläne, um wichtige Handlungsfelder systematisch zu erschließen, und es müssten größere Anreize geschaffen werden, um innovative Projekte umzusetzen.

Nun kommt es zunächst darauf an, dass die spärlichen 100 Millionen Euro Entwicklungsbudget auf dem Weg zu den Entwicklerteams und Projektplanern in ganz Europa nicht in den Verwaltungen versickern. Es wäre nicht das erste Mal.