Erinnerungen sind nie authentisch. Erfolge und Niederlagen erfahren mit wachsendem zeitlichen Abstand erstaunliche Transformationen. Aus einer unappetitlichen Schmach wird im Laufe der Jahre und Jahrzehnte gerne ein heroisches Scheitern. Aus banalem Tagwerk wird schon mal ein hart errungener Triumph. Kein Wunder also, dass auch politische Retrospektiven immer umstritten bleiben. War Helmuth Schmidt tatsächlich der hellsichtigste unter den deutschen Nachkriegsregierungschefs? Oder ragt nicht doch der ungeliebte Wiedervereinigungskanzler Helmut Kohl für alle Zeiten uneinholbar heraus – Trotz aller Spendenaffären und Familientragödien? Die Deutung derartiger Leistungen wird immer von politischen, sozialen und gegenwartsgeprägten Standpunkten aus vorgenommen – und bleiben dementsprechend Interpretationen.

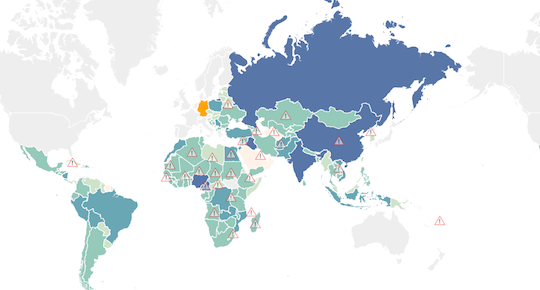

Es verwundert also nicht, dass die Bemühungen wachsen, auch die Analyse zeitgeschichtlicher Ereignisse mit Hilfe von Datenkorrelationen und Datenanalysen zu objektivieren. Wir sprachen an dieser Stelle beispielsweise schon von neuen Formen der Geschichtsschreibung unter dem Schlagwort Data Driven History. Gemeint ist der Versuch, durch die Auswertung historischer Datensätze etablierte Geschichtsbilder zu vervollständigen oder im besten Fall sogar zu erschüttern. Die Auswertungsstrategien erstrecken sich dabei von der Korrelation der Zahl historischer Fundstellen oder Umfang der Funde prähistorischer Artefakte bis hin zu sprachanalytischen Auswertungen von Begriffskonjunkturen in Dokumenten zurückliegender Jahrhunderte.

Das Data Blog des britischen Guardian hat sich nun mit den Spuren beschäftigt, die die Iron Lady, Margaret Thatcher, im Vereinigten Königreich hinterließ. Das Ganze ist natürlich streng datenbasiert. Anlass ist der Start des Kinofilms The Iron Lady, in dem Meryl Streep die mittlerweile an Demenz erkrankte Margaret Thatcher darstellt. Die Produktion hatte in Großbritannien für heftige Debatten gesorgt. Neben der Frage, ob es angemessen ist, ein sogennantes Biopic, also die Verfilmung einer Lebensgeschichte, über Sein und Wirken einer lebende Persönlichkeit zu produzieren, die sich vermutlich nicht mehr mit all ihren geistigen Kräften zur Wehr setzen kann, ist die Bewertung zurückliegender politischer Leistungen Kern der gesellschaftlichen Auseinandersetzung.

Keine Wunder also, dass der Guardian bemüht war, die Leistungen der ehemaligen Regierungschefin mit neuen Methoden sichtbar zu machen beziehungsweise in Frage zu stellen. In einer ganzen Reihe von Infografiken zeigt das Data Blog Team des Guardian, wie sich Großbritannien in der Regierungszeit Margaret Thatchers veränderte. Zu den interessantesten Visualisierungen der Vergangenheit gehören dabei unter anderem Darstellungen der Heirats- und Scheidungsquote. Während die Zahl der Trennungen mehr oder weniger konstant blieb, weist die Statistik einen eindeutigen Rückgang an Hochzeiten auf. Das führt umgehend zu weiteren Fragen: Ist der Regress auf die abschreckende Wirkung der Eisernen Lady auf heiratswillige Männer zurückzuführen oder einfach nur eine Erscheinung der zunehmend unverbindlicheren Lebensstile in einer post- oder sogar postpostmodernen Gesellschaft?

Die Arbeitslosenquote wiederum besitzt eine ganz eigene Dramaturgie. In den knapp eineinhalb Jahrzehnten ihrer Regentschaft konnte Margaret Thatcher alles vorweisen, was man Politikern vorwirft oder wofür man ihnen typischerweise dankt. Erst ging die Quote der Erwerbslosen dramatisch nach oben, dann wieder dramatisch nach unten. Bleibt also die Frage, wie groß das Verdienst beziehungsweise das Verschulden ist.

Ein eher wirres Bild zeigt die Visualisierung der Konjunkturdaten. Die Ausschläge sind stark. In beide Richtungen.

Die Preisentwicklung, insbesondere die Immobilienpreise, dagegen sprechen eine eindeutige Sprache. Ihr Anstieg ist steil, sehr steil. Nicht gerade das, was sich Mieter und Häuslebauer wünschen. Aber natürlich ideal für all jene, die schon Grund und Haus beziehungsweise Häuser besitzen.

Klar wird also anhand dieser Beispiele, das alles weiter unklar ist – trotz der Anschaulichkeit der Vergangenheit durch Datenvisualisierung. Die Bewertung politischer Leistungen ist weiter Interpretationssache. Jede Statistik, jede Infografik, jede Visualisierung ist nur soviel wert, wie der Kontext in dem sie auftaucht oder das Wissen, in dessen Licht der Betrachter sie einordnet. Die Wahrheit wird dauerhaft umstritten bleiben. Auch im Zeitalter von Big Data.