Mehr als drei Jahre lang haben Archivare des National Archive in den USA daran gearbeitet, die Daten der Volkszählung aus dem Jahr 1940 zu digitalisieren.

Diese Daten sind ab dem heutigen Montag im Netz verfügbar und können durchsucht und heruntergeladen werden. Nutzungsbeschränkungen gibt es keine.

Durchgeführt wurde die Befragung damals eigentlich, um zu ermitteln, wie viele Sitze die einzelnen amerikanischen Bundesstaaten im Kongress zu beanspruchen haben, da sich diese Zahl nach der Bevölkerung richtet. Außerdem sollte dabei überprüft werden, wie korrekt die Geburtsregister geführt werden. Neben den Befragungen wurden dazu auch die Registerkarten ausgewertet – allerdings sind die dabei gewonnenen Daten nicht erhalten geblieben.

Doch auch ohne diese ist der Datenschatz gewaltig. Insgesamt 3,8 Millionen auf Mikrofilm gespeicherte Fotos mit den Fragebögen von mehr als 20 Millionen Menschen wurden gesichtet und aufbereitet. In diesen Bögen fragten die „Enumerators“, die Volkszähler, nicht nur nach Standardinformationen wie Name, Alter, Geschlecht, Hautfarbe, Bildung und Geburtsort. Sie wollten auch wissen, wie hoch das wöchentliche Einkommen des Befragten war, wo ihre Eltern geboren wurden und bei Frauen, wie oft sie verheiratet waren.

Die Frage nach dem Einkommen sorgte damals für heftige Debatten und ein republikanischer Senator versuchte, sie aus dem Bogen streichen zu lassen. Ohne Erfolg, doch konnten die Befragten die Antwort verweigern, wenn sie das wollten – es wollten aber nur zwei Prozent.

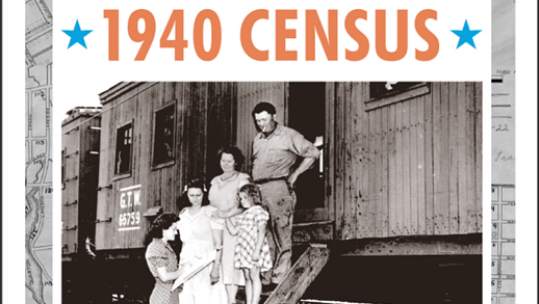

Die Daten böten heute einen historisch interessanten Einblick in die Zeit der großen Depression, schreibt das Nationalarchiv in der Ankündigung dazu auf seiner Website. Sie erzählen das Leben von 132 Millionen Amerikanern, in einer Zeit, als das Land sich durch Wirtschaftskrise und Weltkrieg wandelte.

Etwas mühsam ist allerdings die Suche darin. Denn verschlagwortet sind die Informationen nach den Befragungsbezirken von damals. Wer also seinen Großvater sucht, muss wissen, wo er damals wohnte und dann auf bereitgestellten Karten nachschauen, in welchem Befragungscluster (enumeration district) diese Adresse lag. Ein Personenindex ist in Arbeit, aber noch nicht fertig. Er soll in sechs bis neun Monaten verfügbar sein, wie es bei der Eröffnungsveranstaltung hieß.