Von Jürgen Maier und Thorsten Faas

Ministerpräsident Stefan Mappus (CDU) hat sich durchgesetzt. Überlegungen des SWR, nicht nur den CDU-Spitzenkandidaten und seinen Herausforderer von der SPD, Nils Schmid, für eine Fernsehdebatte einzuladen, sondern auch den Top-Kandidaten von Bündnis 90/Die Grünen, Winfried Kretschmann, erteilte er eine klare Absage: „Für Trio-Konstellationen stehe ich nicht zur Verfügung. Ein Duell besteht aus zwei Personen, wie der Name schon sagt.“ Tatsächlich kommt es nun am 16. März zu einem Aufeinandertreffen von Mappus und Schmid.

Ministerpräsident Stefan Mappus (CDU) hat sich durchgesetzt. Überlegungen des SWR, nicht nur den CDU-Spitzenkandidaten und seinen Herausforderer von der SPD, Nils Schmid, für eine Fernsehdebatte einzuladen, sondern auch den Top-Kandidaten von Bündnis 90/Die Grünen, Winfried Kretschmann, erteilte er eine klare Absage: „Für Trio-Konstellationen stehe ich nicht zur Verfügung. Ein Duell besteht aus zwei Personen, wie der Name schon sagt.“ Tatsächlich kommt es nun am 16. März zu einem Aufeinandertreffen von Mappus und Schmid.

Fernsehdebatten (oft etwas martialisch auch als „TV-Duelle“ bezeichnet) sind ein aus den USA importiertes Format, in dessen Rahmen die aussichtsreichsten Kandidaten für das Amt des Regierungschefs miteinander die zentralen Themen des Wahlkampfs diskutieren. In der Regel sind es tatsächlich zwei Kandidaten, die sich dabei gegenüberstehen. Allerdings gab und gibt es Ausnahmen davon: Der prominenteste Fall sind die TV-Debatten im amerikanischen Präsidentschaftswahlkampf 1992, als der demokratische Herausforderer Bill Clinton nicht nur mit dem damaligen republikanischen Präsidenten George Bush sen., sondern auch mit dem unabhängigen Kandidaten Ross Perot diskutierte. Auch bei der Erstauflage solcher Debatten in Großbritannien im vergangenen Jahr waren drei Kandidaten geladen: Gordon Brown für Labour, James Cameron für die Conservatives und Nick Clegg für die Liberalen.

Auch in Deutschland wäre ein Dreikampf kein Novum. In den Landtagswahlkämpfen 2004 und 2009 in Brandenburg und Thüringen standen sich Vertreter von CDU, SPD und PDS bzw. Die Linke gegenüber. Ein „Duell“ besteht also nicht immer aus zwei Personen. Nun könnte man argumentieren, dass es sich hierbei eigentlich nicht um TV-Duelle, sondern um Elefantenrunden – also eine Diskussion zwischen Repräsentanten aller im Parlament vertretenen Parteien – handelte. Dies stimmt jedoch nur für Thüringen (hier saßen tatsächlich nur diese drei Parteien im Landtag). In der brandenburgischen Volksvertretung war zum Zeitpunkt der Fernsehdebatten allerdings auch die DVU vertreten – der man allerdings keine öffentliche Bühne geben wollte. Auf diese Weise kam es zumindest in Brandenburg schon einmal zu einem aus drei Personen bestehenden Duell.

Die Rationalität hinter diesem Vorgehen war die hohe Popularität der eingeladenen politischen Kräfte – sowohl in den USA als auch in Großbritannien als auch in Thüringen und Brandenburg. Aus diesem Grund regt sich auch in Baden-Württemberg Widerstand. Bündnis 90/Die Grünen reagierten in einem offenen Brief an den Intendanten des SWR auf die Entscheidung des Fernsehsenders. Sie argumentieren unter Berufung auf Umfrageergebnisse, dass ein Ausschluss von Kretschmann die (sich abzeichnenden) politischen Kräfteverhältnisse „verzerren“ würde. Im Kern geht es den Grünen natürlich nicht nur um bloße Sichtbarkeit, sondern vor allem um die Möglichkeit, ein vergleichsweise großes Publikum direkt, d.h. unter Umgehung journalistischer Selektionskriterien, anzusprechen. Damit verknüpft ist die Hoffnung, dass dieser direkte Zugang zu den Wählern sich positiv auf die eigenen Wahlchancen niederschlägt. Wissenschaftliche Untersuchungen zu den TV-Debatten auf Bundesebene belegen immer wieder, dass diese Hoffnung durchaus zur Realität werden kann.

Wie kann man die Situation nun auflösen? Kurzfristig damit, nochmals darüber nachzudenken, ob das Duo Mappus-Schmid nicht doch um den Grünen Kretschmann ergänzt werden sollte. Dies muss – wie ein Blick nach Österreich zeigt – nicht unbedingt darin münden, alle drei Kandidaten gemeinsam vor der Kamera stehen. In der Alpenrepublik debattiert traditionell jeder gegen jeden. Alternativ dazu könnte man natürlich auf eine Elefantenrunde ausweichen – und auch Liberale (und Linke?) zu einer Diskussion bitten. Mittelfristig müssen klarere Regeln her, wann Parteien einen Repräsentanten in ein solches Duell entsenden dürfen. Zwar wurde vom Bundesverfassungsgericht 2002 entschieden, dass ein solcher Anspruch generell nicht besteht und die Fernsehsender (und zwar auch die öffentlich-rechtlichen) in der Zusammenstellung solcher Diskussionsrunden grundsätzlich frei sind. Aber auch hier könnte ein Blick in die USA weiterhelfen: Dort werden alle Kandidaten geladen, die eine rechnerische Chance haben, die Mehrheit im Electoral College zu gewinnen, bzw. die in landesweiten Umfragen mindestens 15 Prozent der Wähler hinter sich vereinigen können. Außerdem liegt die Organisation solcher Debatten dort in den Händen einer unabhängigen „Commission on Presidential Debates“, was auch der Situation in Deutschland angesichts der zu beobachtenden Institutionalisierung solcher Diskussionsrunden sicher gut tun würde.

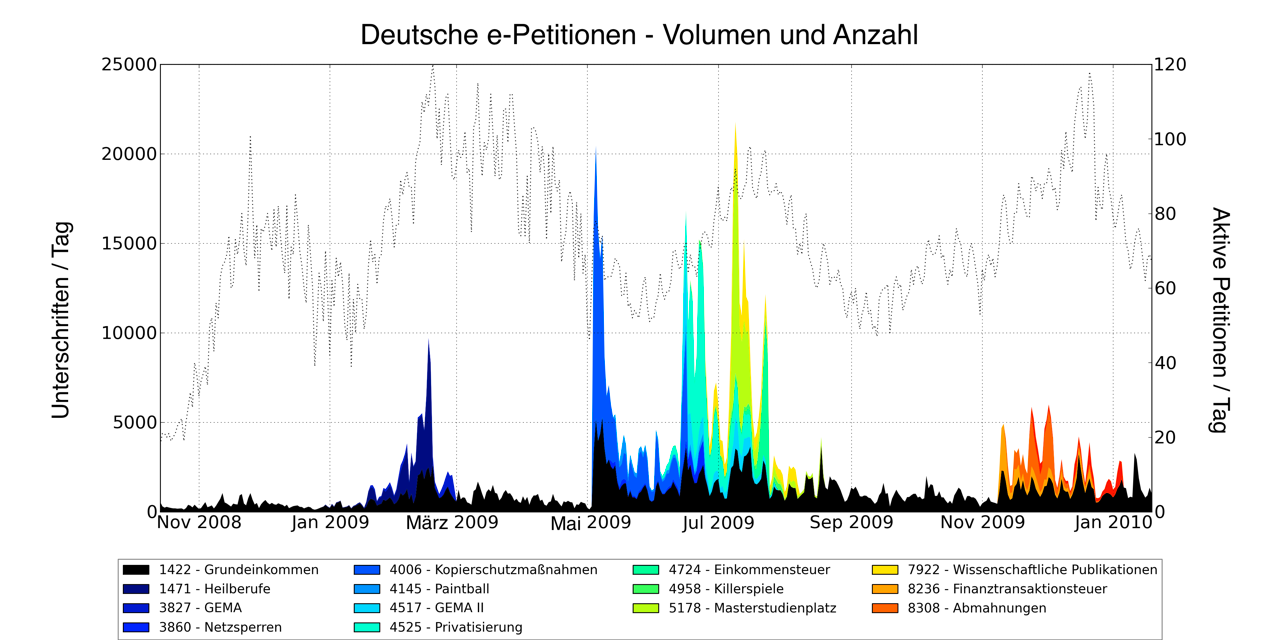

Geht man nach den Nutzerzahlen, so gehört das E-Petitionssystem des Deutschen Bundestages zu den erfolgreichsten Beispielen für demokratische Partizipation über das Internet. Tatsächlich bündeln jedoch nur sehr wenige E-Petitionen mehr als die Hälfte aller Unterschriften. Die öffentliche Unterstützung konzentriert sich also auf einem verschwindend kleinen Bruchteil aller öffentlichen E-Petitionen. Das E-Petitionssystem scheint allerdings nicht dem “Winner takes all”-Prinzip zu folgen. Auch wenn nur ein kleiner Bruchteil der E-Petitionen einen Großteil der Unterstützung auf sich konzentriert, profitieren auch kleinere, weniger erfolgreiche E-Petitionen von der Aufmerksamkeit, die erfolgreiche E-Petitionen erregen. Es scheint, als ob Aufmerksamkeit und Unterschriften von erfolgreichen auf weniger erfolgreiche E-Petitionen gleichsam überspringen.

Geht man nach den Nutzerzahlen, so gehört das E-Petitionssystem des Deutschen Bundestages zu den erfolgreichsten Beispielen für demokratische Partizipation über das Internet. Tatsächlich bündeln jedoch nur sehr wenige E-Petitionen mehr als die Hälfte aller Unterschriften. Die öffentliche Unterstützung konzentriert sich also auf einem verschwindend kleinen Bruchteil aller öffentlichen E-Petitionen. Das E-Petitionssystem scheint allerdings nicht dem “Winner takes all”-Prinzip zu folgen. Auch wenn nur ein kleiner Bruchteil der E-Petitionen einen Großteil der Unterstützung auf sich konzentriert, profitieren auch kleinere, weniger erfolgreiche E-Petitionen von der Aufmerksamkeit, die erfolgreiche E-Petitionen erregen. Es scheint, als ob Aufmerksamkeit und Unterschriften von erfolgreichen auf weniger erfolgreiche E-Petitionen gleichsam überspringen.