Das Geschäft mit Land boomt – spätestens, seit die Nahrungspreise steigen, fruchtbares Land auch für den Anbau von Treibstoffpflanzen benötigt wird und Investoren mit Aktien und Anleihen nicht mehr so viel Geld verdienen können wie vor der Finanzkrise. „Land Grabbing„, die Aneignung von Flächen durch Investoren auf Kosten der lokalen Bevölkerung, ist zu einem großen Thema geworden.

Die Öffentlichkeit erfährt oft nichts über die Bedingungen der Landverkäufe. Auch gibt es noch keinen Überblick über Ausmaß, Ziel und Folgen der bisher abgeschlossenen Landgeschäfte. Eine neue Datenbank soll das jetzt ändern: die „Land Matrix“ veröffentlicht Informationen zu großen Landverkäufen oder -pachtgeschäften. Seit heute ist sie online, als Teil der umfassenderen Plattform „Land Portal“, die Informationen und Debatten rund um das Geschäft mit Land bündelt.

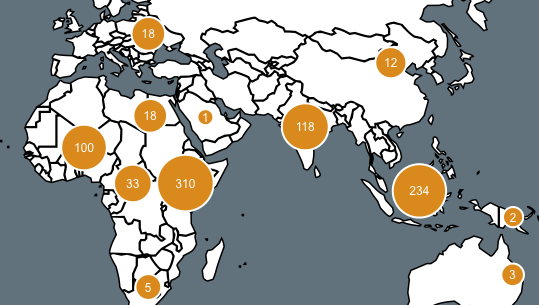

Den Betreibern zufolge versammelt die Datenbank Informationen über Landgeschäfte, die seit dem Jahr 2000 für land- oder forstwirtschaftliche Zwecke, für Rohstoffabbau, Tourismus oder Naturschutz abgeschlossen wurden. Insgesamt umfasse sie mehr als 2.200 Transaktionen. Öffentlich einsehbar ist bislang nur etwa die Hälfte. Der Rest müsse noch verifiziert werden und werde nach und nach hinzugefügt, heißt es auf der Seite. Gleiches gelte für neue Fälle, die jeder per E-Mail (report@landportal.info) melden kann.

Hinter der Matrix stecken große Organisationen der Entwicklungspolitik und Forschungsinstitute, unter ihnen die International Land Coalition, zu der die Weltbank ebenso gehört wie Nichtregierungsorganisationen, die Deutsche Gesellschaft für Internationale Zusammenarbeit (GIZ) und das German Institute for Global and Area Studies (GIGA). Gefördert wird das Projekt unter anderem durch Oxfam, das deutsche Entwicklungsministerium und die Europäische Kommission.

Als Quellen nutzen die Datensammler die Berichterstattung der Medien, Reports von Nichtregierungsorganisationen, die teils bereits im Netz verfügbar sind, oder Berichte aus empirischen Forschungsprojekten. Unternehmens-Webseiten und Regierungsakten werden ebenfalls ausgewertet, sofern sie öffentlich zugänglich sind. Zur Verifizierung werden die Daten miteinander verglichen und durch Partner in den betroffenen Ländern überprüft.

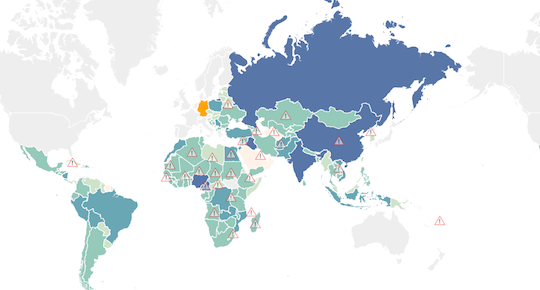

User können die bisher verifizierten Daten problemlos im .csv-Format herunterladen – also als Textdatei, die von gängigen Tabellenkalkulationsprogrammen wie Excel oder OpenOfficeCalc erkannt und verarbeitet werden kann. Die interaktiven Schaubilder der Seite veranschaulichen die Trends des Geschäfts. Sie lassen sich leider nicht anderswo einbinden. Nur ein Teil der Grafiken kann als PDF heruntergeladen werden. Sämtliche Informationen stehen unter der Creative-Commons-Lizenz BY-NC-SA 3.0.

Ob Weltbank, ihre Kritiker oder die beteiligten Forscher: Sie alle erhoffen sich von der Land Matrix Aufschluss darüber, wie hilfreich oder schädlich das globale Geschäft mit Land tatsächlich ist. Die Deals sind nicht zwangsläufig unsozial. Institutionen wie die Weltbank und die Welternährungsorganisation setzen sogar darauf, durch größere Investitionen die Erträge der Landwirtschaft in Entwicklungsländern zu erhöhen.

Entwicklungsorganisationen halten dagegen: Die Kämpfe ums Land würden brutaler, gewaltsame Vertreibungen seien an der Tagesordnung, das Menschenrecht auf Nahrung werde „tausendfach verletzt“. Zwar scheint es bislang nicht viele positive Beispiele zu geben, aber zumindest Einzelfälle zeigen: Würden die Rahmenbedingungen stimmen, könnten alle etwas vom Geschäft haben.

Eine erste Auswertung der Daten durch die beteiligten Forscher legen drei Schlüsse nahe: Landgeschäfte gehen häufig tatsächlich zu Lasten der lokalen Bevölkerung. Sie finden vor allem in Ostafrika und Südasien statt. Und: groß angelegte Land-Investitionen sind kein vorübergehendes Phänomen, sondern ein Trend, der erst einmal anhalten wird.

Eine detaillierte Auswertung der Ergebnisse erscheint in Kürze im Wirtschaftsressort von ZEIT ONLINE.