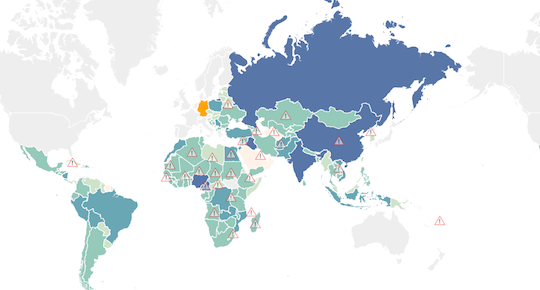

Vor einigen Wochen fand in Berlin die Open Aid Data Konferenz statt. Die Möglichkeiten der Optimierung von Geldflüssen und Projektausrichtungen in der Entwicklungshilfe wurden diskutiert. Dass Open Data Entwicklungszusammenarbeit verbessern kann, ist seit Längerem klar. Jetzt hat der Open-Data-Aktivist und Macher des Hyperlocalportals Frankfurt-Gestalten.de, Christian Kreutz, für die Open Knowledge Foundation Germany eine Weltkarte deutscher Geldflüsse im Kontext Entwicklungszusammenarbeit erstellt.

Auf dem ZDF-Blog Hyperland erschien daraufhin ein Making-Of der Karte unter dem Titel „Wie ein Daten-Mashup die deutsche Entwicklungshilfe aufschlüsselt„. Hochspannend erklärt die Autorin Christiane Schulzki-Haddouti im Blogpost, wie die Daten erschlossen wurden, welche eklatanten Defizite es bei der Datenbereitstellung noch gibt und welche überraschenden Erkenntnisse das Mash-Up liefert.

Zum Beispiel fließen die mit Abstand meisten Mittel aus deutschen Fördertöpfen nicht nach Afrika, wie man vielleicht mit Blick auf dortige Hungerkatastrophen erwarten könnte, sondern in die sogenannten BRIC-Länder: Brasilien, Russland, Indien und China.