In seinem Blog The Future Buzz möchte Adam Singer einen Mythos wiederlegen: Den von der notwendigen Kürze von Texten im Internet. Er bezieht sich dabei auf einen aktuellen Post seines Bloggerkollegen Rob Birgfeld, der (wie so viele vor ihm) behauptet, dass längere Texte im Netz keinen Erfolg hätten. Und der daraufhin ein paar Regeln für gute Blogposts formuliert.

Zu den Tipps, die Birgfeld für gute Texte gibt, gehört etwa der Hinweis auf kurze Titel und Ankündigungen: Man solle seinen Punkt in 140 Zeichen klarmachen können, Linkadresse inklusive, in Tweetlänge also. Wenn man zudem wünsche, dass jemand den eigenen Hinweis retweete, solle man weitere 15 Zeichen herauswerfen.

Außerdem sollten Blogger ihre Beiträge „vom Kopf auf die Füße stellen“, rät Birgfeld. Soll heißen, schneller auf den Punkt kommen und auf umständliche Einstiege verzichten. Auch Video-Beiträge sollte man so kurz halten wie möglich. Sind sie länger als fünf Minuten sollten sie Hinweise enthalten, an welcher Stelle ein konkretes Thema zur Sprache komme. Im Web, wo alles von Mund zu Mund weitergetragen werde, müssten die Informationen eben auch mundgerecht serviert werden, argumentiert Birgfeld: In kleinen, gut zu kommunizierenden Häppchen eben.

Adam Singer hält diese vermeintlichen Schreibregeln für pure Behauptungen, für die es bis auf weiteres an Beweisen mangele. „Wenn man sich einige der populärsten digitalen Persönlichkeiten im Netz anschaut, wird man hingegen feststellen, dass ihre Texte eher in die Tiefe gehen“, schreibt er.

Die Pflicht zur Kürze scheint eher durch ständige Wiederholung zu einer Regel geworden zu sein, als durch überprüfbare Fakten, glaubt Singer. Entscheidend seien eben gute Einstiege, gute Videos und gute Texte, die dürfen dann eben auch lang sein, und zwar genau so lang, wie ihre Inhalte tragen: „Of course, don’t go longer than you can be interesting.“

Im Netz ließen sich sowohl komplexe als auch simple Ideen verbreiten. Ob diese zwischen Communities weitergetragen würden, hänge nicht davon ab, wie kurz sie seien, sondern ob sie es wert seien, weitererzählt zu werden.

Und in der Tat, wenn man sich die Debatten in und übers Netz so anschaut, hat man nicht das Gefühl, dass sie nun ausgerechnet unter mangelnder Komplexität leiden. Ob nun Jeff Jarvis fragt: „Was würde Google tun?“, Chris Anderson: „The Long Tail“ erklärt oder Nicholas Carr fragt, was das Internet mit unserem Gehirn anstellt, dann passt die Frage zwar in eine Twitterzeile. Aber die Thesen sind groß genug, unzählige Blogs zu füllen.

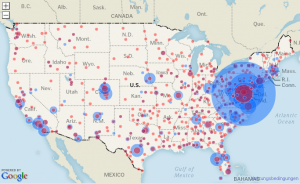

Auch die Ortsinformationen der Behörden und Unternehmen haben die Journalisten ausgewertet und auf GoogleMaps verortet. Man erkennt die historischen Schwerpunkte des Militär-Industrie-Komplexes in Virginia, Florida, Colorado und Kalifornien.

Auch die Ortsinformationen der Behörden und Unternehmen haben die Journalisten ausgewertet und auf GoogleMaps verortet. Man erkennt die historischen Schwerpunkte des Militär-Industrie-Komplexes in Virginia, Florida, Colorado und Kalifornien.