Stündlich, minütlich ändert sich in Japan jetzt die Lage. Für die Betroffenen sind Nachrichten über das Atomkraftwerk Fukushima-1 wichtig, noch wichtiger sind jedoch Informationen darüber, wo sie in ihrer Umgebung am schnellsten Hilfe finden. Wo gibt es Unterkunft, wo gibt es etwas zu essen?

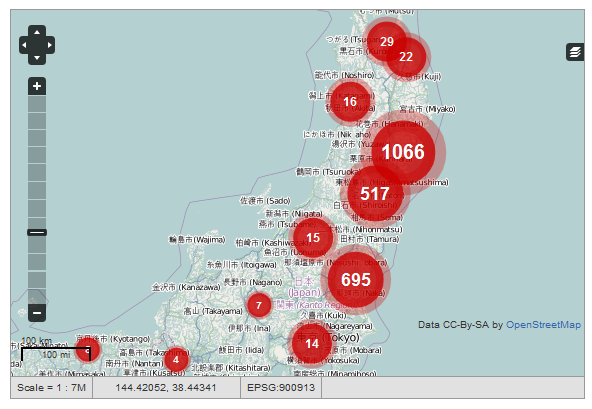

In Japan wurde nun die Ushahidi-Plattform aufgesetzt, um den Katastrophenopfern zu helfen. Ushahidi wurde 2008 in Kenia entwickelt, um die Unruhen nach den Wahlen zu dokumentieren. Das Wort bedeutet „Zeuge“ und die Plattform hat es sich zur Aufgabe gemacht, lokale Entwicklungen zu dokumentieren. Jeder Bürger kann mit seinem Handy Informationen beitragen.

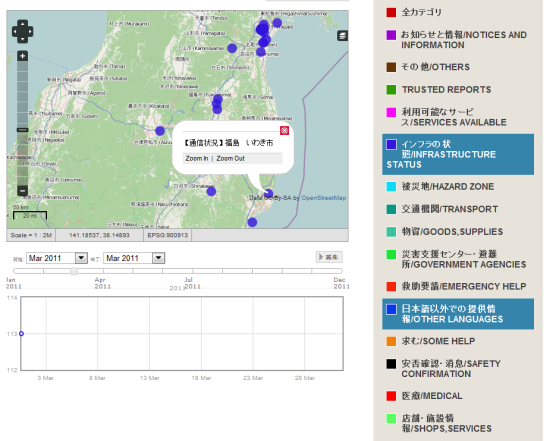

Die Daten werden im Crowdsourcing-Verfahren von vielen Freiwilligen erhoben und in verschiedene Kategorien wie etwa „Vertrauenswürdige Berichte“, „Zustand der Infrastruktur“, „Versorgung“, „Gefahrenzone“ oder „Andere Sprachen“ eingeordnet. Aber auch Daten des Wetterdienstes zu den neuesten Erdbeben werden automatisiert eingelesen. Das ist wichtig, da es nahezu ununterbrochen zu mehr oder weniger schweren Nachbeben kommt. So kann Hilfe geleistet – aber auch ein minutiöser Überblick über die Entwicklung behalten werden:

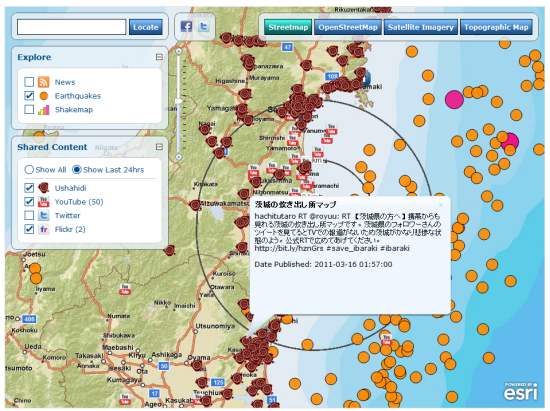

Die Ushahidi-Daten können wiederum über offene Schnittstellen in andere Dienste importiert werden, zum Beispiel in diese Krisenkarte des Geodatenunternehmens Esri, die die Daten in einem Mashup zusammen mit RSS-Nachrichtentickern, Erdbebendaten, Twitter- und Youtubeinformationen anzeigt. Die Youtube-Einträge sind allerdings in vielen Fällen nicht treffend lokalisiert, auch die Nachrichtenmeldungen passen noch nicht ganz. Dafür dass die Karte aber erst vor wenigen Tagen eingerichtet wurde, bietet sie eine gute Orientierung.

Ein Klick auf den Link, der in die oben ausgewählten Ushahidi-Meldung eingefügt wurde, führt beispielsweise weiter zu einem Mobildienst, der über die Einbindung von GoogleMaps anzeigt, an welchen Orten es Verpflegung und Unterkunft gibt: