Die Deutschen lieben Mineralwasser. Nicht nur, dass sie zu den größten Konsumenten weltweit gehören; der Durchschnittsdeutsche trinkt auch viel mehr abgefülltes Wasser als früher. Noch im Jahr 1970 lag der jährliche Verbrauch pro Kopf bei rund 13 Litern Mineral- und Heilwasser. Mittlerweile hat sich die Menge verzehnfacht. Hinzu kommt ein Pro-Kopf-Verbrauch von gut fünf Litern Quell- und Tafelwasser.

Womöglich ist der Verbrauch derart angestiegen, weil man sich mit steigendem Wohlstand lieber abgefülltes Mineralwasser gönnt, statt schnödes Trinkwasser aus der Leitung zu zapfen. Dabei ist dessen Qualität mindestens genauso gut, sagen Verbraucherschützer – und Leitungswasser kostet auch viel weniger. Zwischen den Bundesländern gibt es allerdings große Unterschiede, wie die Grafik zeigt. In Bayern, Hamburg, Niedersachsen und Schleswig-Holstein war Leitungswasser im Jahr 2010 besonders günstig, im Saarland, Sachsen und Thüringen besonders teuer.

Unter den abgefüllten Wässern ist Mineralwasser der absolute Favorit der Konsumenten. Das Gesetz definiert genau, wann ein Wasser als Mineralwasser verkauft werden darf. Es muss aus unterirdischen, vor Verunreinigung geschützten Wasservorkommen stammen und darf laut Gesetz fast gar nicht verändert werden. Die Abfüller dürfen es filtern, belüften, ihm Kohlensäure entziehen oder hinzufügen. Um als „Natürliches Mineralwasser“ gehandelt zu werden, braucht ein Wasser zudem eine amtliche Anerkennung.

Heil- und Quellwasser stammen ebenfalls aus unterirdischen Quellen. Doch während Heilwasser als Arzneimittel gilt, besonders mineralstoffreich sein muss und seine gesundheitsfördernde Wirkung sogar wissenschaftlich belegt sein muss, sind die Anforderungen an Quellwasser weniger streng. Tafelwasser ist im Gegensatz zu den anderen Wässern kein Naturprodukt, sondern kann auch vom Hersteller zusammengemischt werden, etwa aus Leitungswasser, Mineralwasser, Sole, Kochsalz oder Meersalz und weiteren Zusatzstoffen.

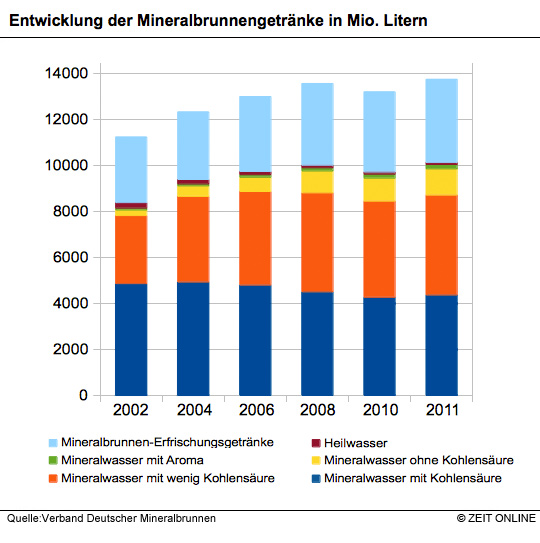

Besonders beliebt sind Mineralwässer mit wenig Kohlensäure und stille Wässer ohne und mit Geschmack. Ihr Absatz hat in den vergangenen Jahren stark zugenommen, während der Verkauf von Sprudelwasser hingegen leicht sank. Auch Erfrischungsgetränke auf Mineralwasserbasis verkaufen sich gut. Fassbrause sei der neue Trend, sagt der Mineralwasserverband, obwohl sie „eigentlich auf eine lange regionale Tradition zurückblicken“ könne.

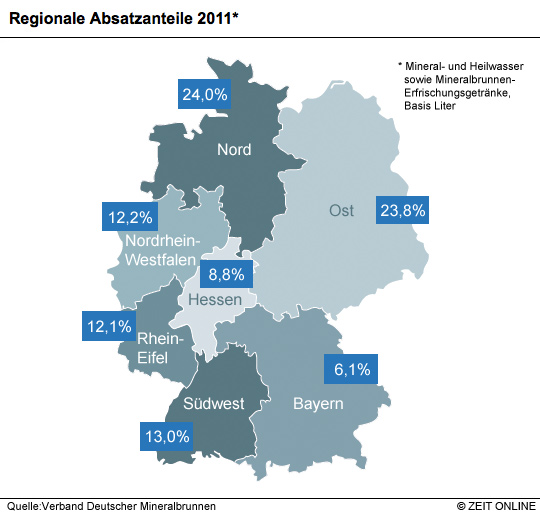

Den Branchenvertretern zufolge gibt es in Deutschland über 500 verschiedene Mineralwässer aus regionalen Brunnen. Die Karte zeigt: Ein beträchtlicher Teil der Wässer wird auch regional vermarktet. Besonders hoch ist die Quote in Nord- und Ostdeutschland. Allerdings ist die Größe der vom Branchenverband ausgewiesenen Gebiete sehr unterschiedlich, und gerade der Norden und Osten fallen besonders groß aus. Gut möglich, dass unter den dort gehandelten und in der Statistik als „regional“ ausgewiesenen Mineralwässern auch solche sind, die über weite Strecken transportiert werden – beispielsweise von Südthüringen nach Berlin. Auffällig ist dennoch, dass ausgerechnet Bayern als relativ großes Flächenland den geringsten Absatzanteil an regionalen Wässern aufweist.

Nur wenige der deutschen Abfüller verkaufen ihr Wasser dem Verband zufolge international. Ebenso wird nur wenig des hier konsumierten Wassers aus dem Ausland eingeführt. Der Importanteil am Umsatz mit Mineral- und Heilwasser, gemessen in Litern, liegt seit Jahren relativ konstant zwischen acht und neun Prozent. Die Wässer, die wir einführen, kommen allerdings auch aus exotischen Gegenden. Aus den Einfuhrdaten des Bundesamtes für Statistik geht beispielsweise hervor, dass der Löwenanteil an importiertem Mineralwasser ohne Kohlensäure aus Frankreich kommt. Aber eine kleine Menge, vermutlich hochpreisiges Luxus-Wasser , stammt von den Fidschi-Inseln. Auch aus Norwegen, Russland, den USA, selbst aus den Vereinigten Arabischen Emiraten und Saudi-Arabien wird Mineralwasser ohne Kohlensäure nach Deutschland importiert. Ob das Wasser auch in der Wüste abgefüllt wurde, verrät die Statistik freilich nicht.

Importiertes kohlensäurehaltiges Mineralwasser kommt überwiegend aus Italien, das Tafelwasser aus den Niederlanden. Gezuckertes Import-Wasser, das nicht unbedingt Mineralwasser sein muss, aber sein kann, stammt vor allem aus Frankreich, Österreich, Dänemark und der Türkei. Und schließlich gibt es noch eine Kategorie von Importwasser, die Mineralwasser ausdrücklich ausschließt, aber Eis und Schnee mit einbezieht. Für solches Wasser sind die Niederlande unser größter Lieferant. Aber winzige Mengen kommen auch aus der Wüste der Vereinigten Arabischen Emirate, von den weit entfernten Salomonen – und sogar aus der Antarktis.